Mô hình LLM được xây dựng dựa trên một khối lượng dữ liệu khổng lồ và là nền tảng để tạo ra các trợ lý ảo hữu ích trong cuộc sống hằng ngày. Sự phát triển của AI tạo sinh và các mô hình LLM sẽ đóng vai trò quan trọng trong việc thúc đẩy chuyển đổi số, gia tăng năng suất lao động trong nhiều ngành, lĩnh vực. Các mô hình LLM tiếng Việt có thể giúp việc dịch máy, nhận dạng giọng nói, trả lời câu hỏi và tóm tắt văn bản bằng tiếng Việt trở nên chính xác và hiệu quả hơn.

Sự bùng nổ của trí tuệ nhân tạo tạo sinh (Generative AI) đã làm thay đổi hoàn toàn bức tranh công nghệ toàn cầu. Từ khi OpenAI ra mắt ChatGPT vào cuối năm 2022, hàng loạt mô hình LLM tương tự liên tục xuất hiện, ứng dụng trong nhiều lĩnh vực như y tế, giáo dục, tài chính, pháp lý… Cuộc đua trở nên gay gắt, không chỉ ở quy mô doanh nghiệp mà còn ở quy mô quốc gia về năng lực huấn luyện, hạ tầng tính toán và dữ liệu.

Các công ty lớn như OpenAI, Google, Meta hay Microsoft với tiềm lực tài chính và điều kiện thuận lợi đều đã "nhanh chân" đầu tư hàng tỷ USD để sở hữu hàng nghìn GPU cao cấp như Nvidia H100 - nhân tố cốt lõi cho việc huấn luyện các mô hình LLM.

Ngoài vấn đề chi phí, doanh nghiệp công nghệ ở các nước đang phát triển còn phải đối mặt với giới hạn về xuất nhập khẩu thiết bị chip AI từ Mỹ. Điều này dẫn đến thiếu thiết bị huấn luyện và "chậm chân" hơn so với các gã khổng lồ công nghệ.

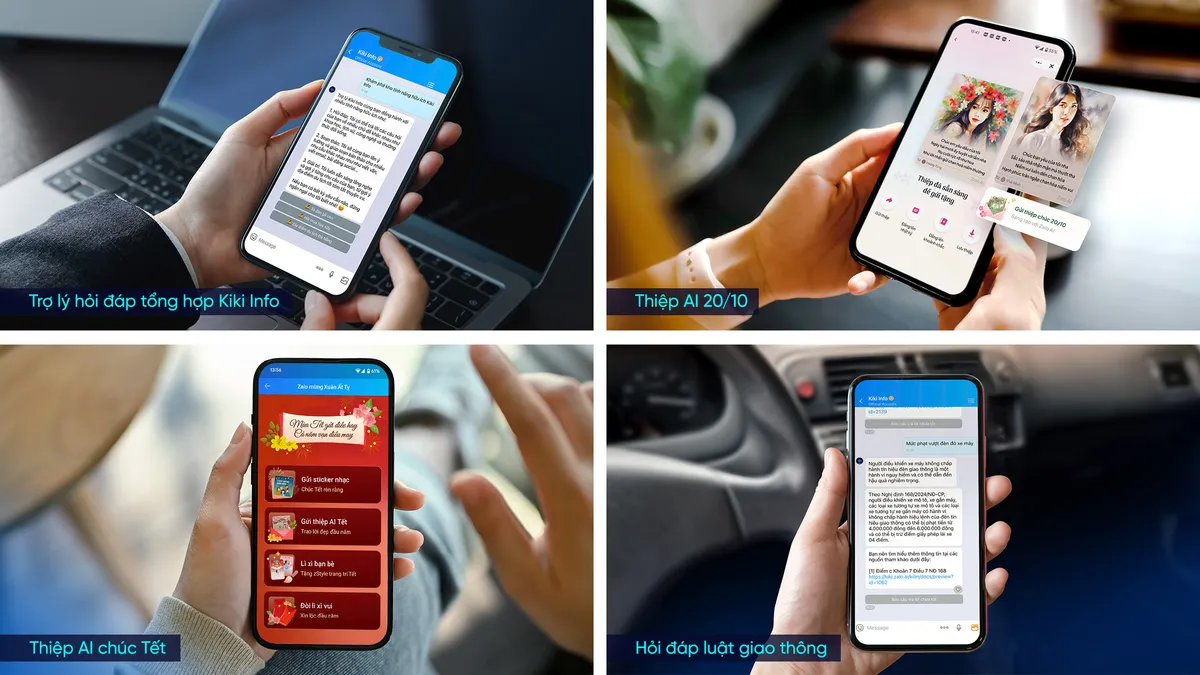

Phát triển LLM tiếng Việt để xây dựng các trợ lý ảo phục vụ người Việt được Bộ Khoa học và Công nghệ đánh giá là một việc rất quan trọng. Do đó, thời gian qua, nhiều hoạt động đã được thực hiện để thúc đẩy việc phát triển LLM tiếng Việt và các trợ lý ảo dành riêng cho người Việt, trong đó có việc đánh giá, xếp hạng mô hình LLM tiếng Việt của các doanh nghiệp công nghệ số trong nước như Viettel, VNPT, FPT, MISA, VNG...

Lựa chọn con đường tự huấn luyện mô hình LLM từ đầu (from-scratch model), Zalo phải tạo dựng từ con số 0 - từ dữ liệu, kiến trúc mô hình đến toàn bộ quá trình huấn luyện, với nhiều thách thức. Về dữ liệu, những bài toán học máy trước đây đã đòi hỏi lượng dữ liệu huấn luyện lớn nhưng với các mô hình ngôn ngữ lớn, đây là lượng dữ liệu khổng lồ. Để có một mô hình đủ tốt, hệ thống LLM đòi hỏi hàng chục, thậm chí hàng trăm tỷ token văn bản đầu vào. Điều này gây khó khăn với các nhà phát triển LLM của Việt Nam.

Muốn huấn luyện LLM, các kỹ sư cần phải có hạ tầng phù hợp. Nhưng tại thời điểm đó, những GPU như H100 của Nvidia gần như là "hàng hiếm toàn cầu". Trong khi đó, các hãng lớn đã đặt trước cả năm và trả hàng triệu USD để sở hữu.

Trong hoàn cảnh chưa có GPU của Nvidia, các kỹ sư Việt Nam đã phải linh hoạt dùng tạm GPU dân dụng để thực nghiệm trên từng dòng mã, chạy từng mô hình nhỏ. Về mặt dữ liệu, thay vì trông chờ vào nguồn tài nguyên sẵn có thay thế bằng việc đầu tư xây dựng kho dữ liệu chất lượng cao riêng cho tiếng Việt, nhằm bù đắp sự thiếu hụt nghiêm trọng so với tiếng Anh và tiếng Trung.

Bạn không thể gửi bình luận liên tục.

Xin hãy đợi 60 giây nữa.